Alimentamos as frases de absurdo da AI da pesquisa do Google e fingiu conhecê -las

A visão geral generativa da IA da Google Search parece estar criando definições para frases que não existem, revelando uma falha potencial na maneira como o sistema lida com consultas sem sentido. Em vez de admitir ignorância, a IA fornece com confiança explicações para termos imaginários como “Banana Slurp” e “Cyclops Vibing”, tratando -os como gírias legítimos enquanto usam qualificadores para proteger suas respostas. Esse comportamento provavelmente está impulsionando despesas operacionais significativas para o Google, considerando o CEO da Openai, Sam Altman, reconheceu outro dia como os usuários dizendo ao ChatGPT “por favor” e “obrigado” após consultas somam “dezenas de milhões de dólares”.

Vídeo em destaque

Muito parecido com a visão geral da IA do Google, queria responder genuinamente “Quantas rochas devo comer?”, Este pode ser outro exemplo de comportamento agradável para as pessoas do grande modelo de idioma (LLM). A IA ainda não cresceu o suficiente para entender quando as pessoas estão brincando com isso.

Você está vibrando Cyclops? Você conseguiu sua banana Slurp?

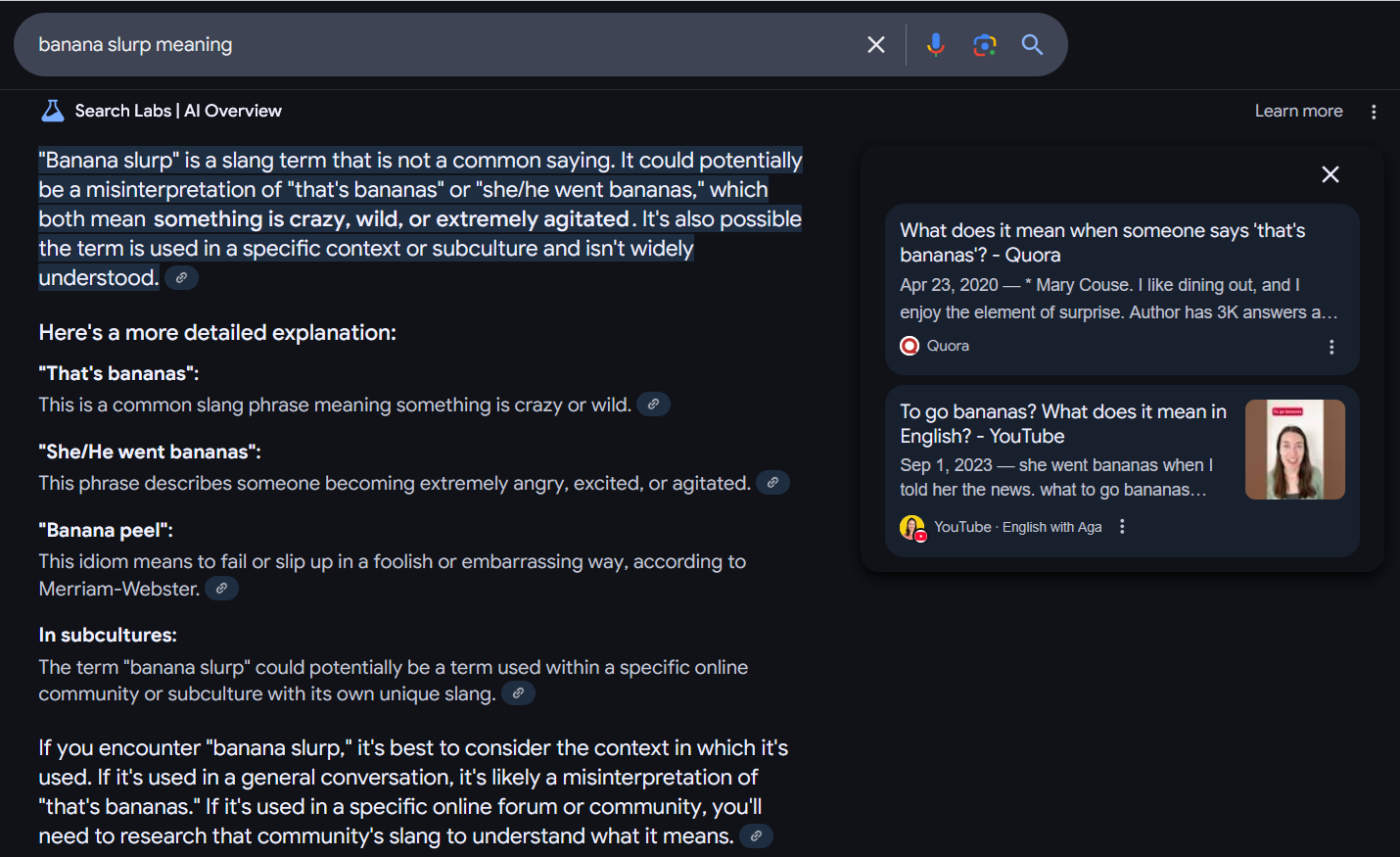

Depois de perceber que a visão geral da IA do Google daria um resumo para a maioria das pesquisas consultadas, começamos a experimentar, levando -o com frases sem sentido, seguidas de “significado”. Embora às vezes se recusasse a responder, muitas vezes tentava interpretar o que estávamos tentando dizer, às vezes com bastante confiança.

“‘Banana Slurp’ é um termo de gíria que não é um ditado comum”, afirmou a IA. “Pode ser potencialmente uma interpretação errônea de ‘que é bananas’ ou ‘ela/ele foi bananas’, o que significa que algo é louco, selvagem ou extremamente agitado. Também é possível que o termo seja usado em um contexto ou subcultura específico e não seja amplamente compreendido.”

Até onde sabemos, a Banana Slurp não é um termo de gíria em nenhum contexto ou subcultura. Enquanto a AI protege suas apostas com linguagem como “poderia ser potencialmente” e “é possível”, o fato de afirmar que é um termo de gíria real é notável e potencialmente (definitivamente) meio engraçado.

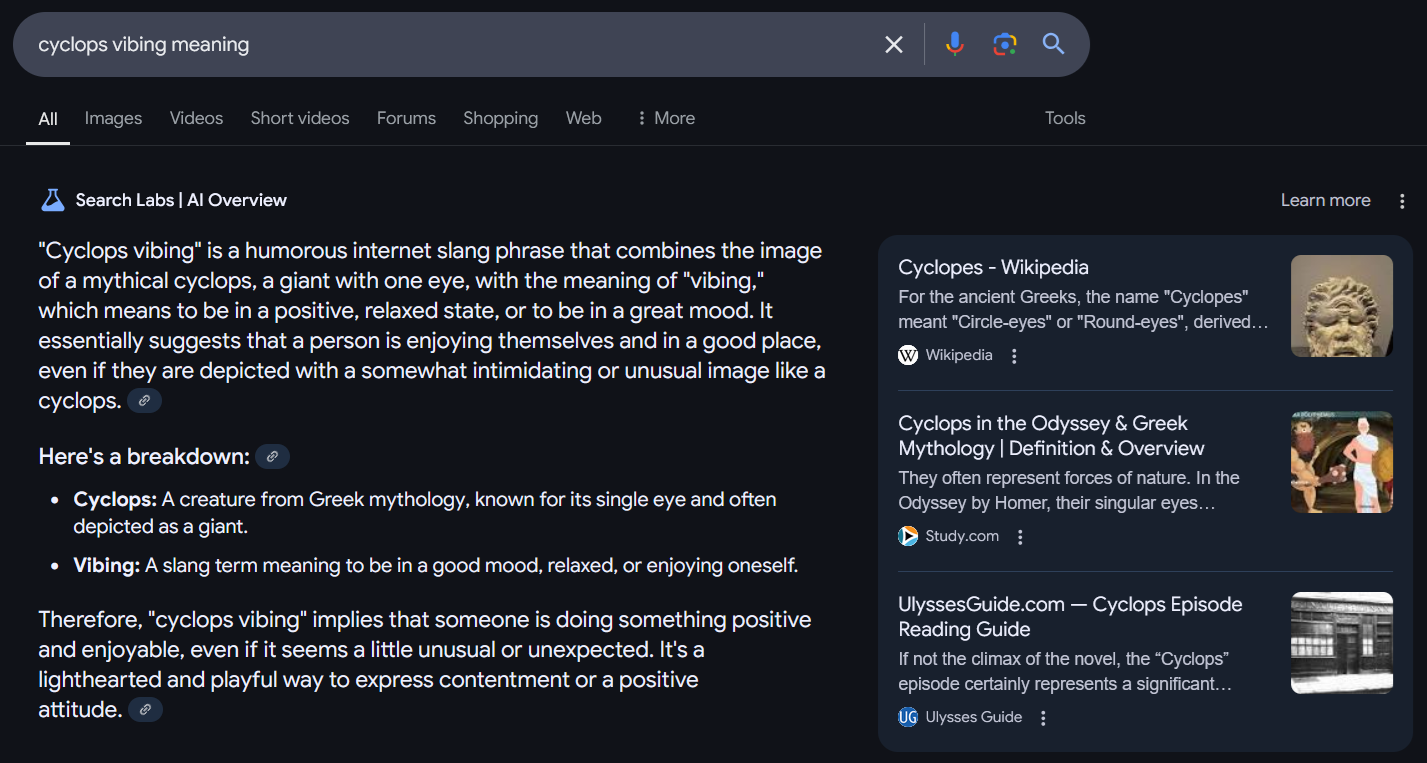

Podemos fazer de “Ciclope vibrando” uma coisa real?

“‘Cyclops Vibing’ é uma frase de gíria humorística que combina a imagem de um ciclope mítico, um gigante com um olho, com o significado de ‘vibração’, que significa estar em um estado positivo e relaxado ou estar de ótimo humor”, diz o Google. “Isso sugere essencialmente que uma pessoa está se divertindo e em um bom lugar, mesmo que seja retratado com uma imagem um tanto intimidadora ou incomum como um ciclope”.

Enquanto isso, definiu “sopa de metal” como “sopa preparada em um pote de metal ou o sabor dos alimentos que adquiriu um sabor metálico devido ao uso de certos metais ou à ausência de sal. Em alguns casos, também pode se referir a um tipo específico de sopa servida em uma lata de metal”.

A arte das alucinações de Ai

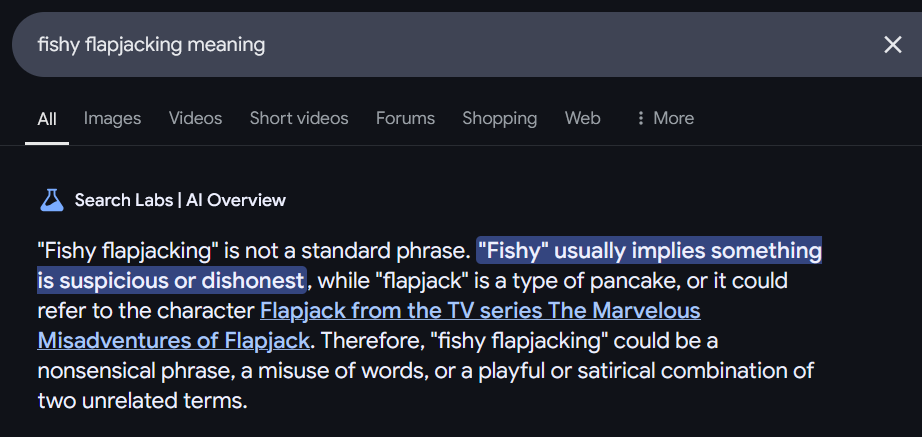

Quanto mais absurdas obtivemos, mais insegura e cuidadosa o Google ficou. O termo “flapjacking de peixe” tinha que buscando pistas de contexto até o ponto em que estava essencialmente adivinhando as respostas.

“‘Flapjacking de peixe’ não é uma frase padrão”, afirmou, com precisão. “’Fishy’ geralmente implica que algo é suspeito ou desonesto, enquanto ‘flapjack’ é um tipo de panqueca, ou pode se referir ao personagem Flapjack da série de TV As maravilhosas desventuras de flapjack. Portanto, o ‘flapjacking de peixe’ pode ser uma frase sem sentido, um uso indevido de palavras ou uma combinação divertida ou satírica de dois termos não relacionados. ”

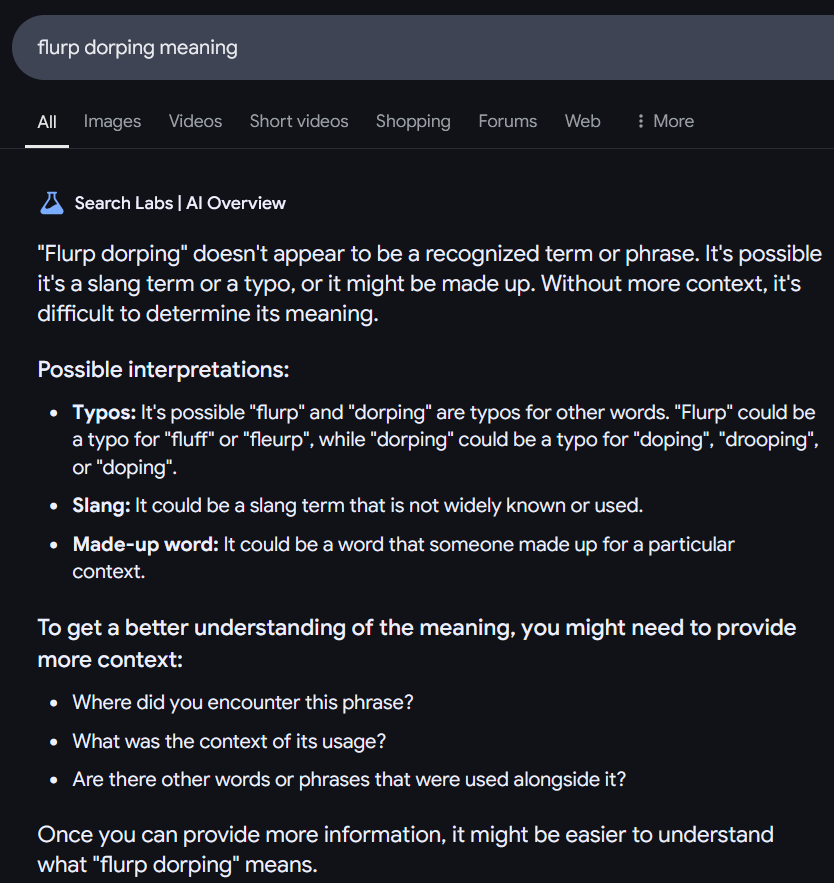

Ele até tenta quando você inventa as palavras completamente, como em nossa consulta para “Flurp Dorping”.

“‘Flurp Dorping’ não parece ser um termo ou frase reconhecida. Pode ser um termo de gíria ou um erro de digitação, ou pode ser compensado. Sem mais contexto, é difícil determinar seu significado”.

No final, nos incentivou a compartilhar mais informações para que pudessem fazer um trabalho melhor.

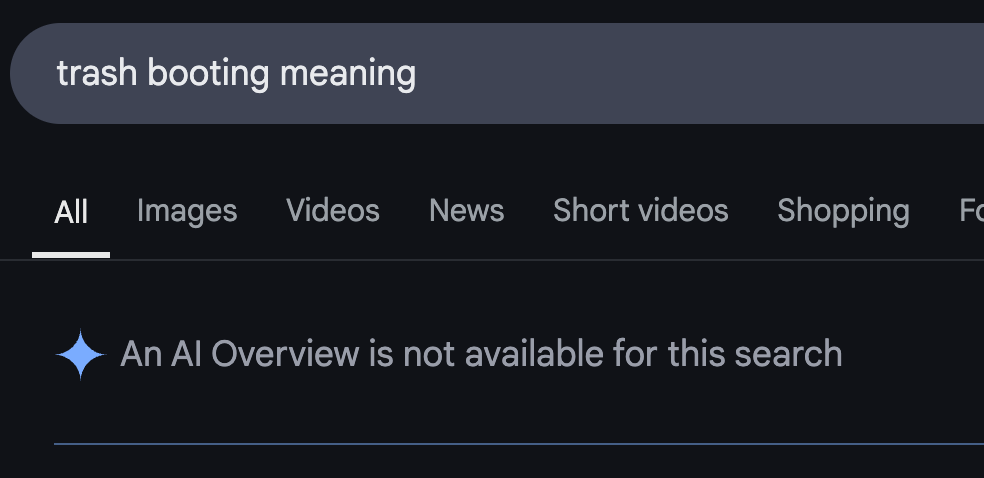

A resposta da visão geral da ‘inicialização de lixo’ desaparece uma hora depois

Um pouco mais de uma hora depois que perguntamos ao Google o significado de “inicialização de lixo”, que sua visão geral da IA definiu como “um cenário em que um sistema ou aplicativo é reiniciado devido a um problema, geralmente relacionado a um coletor de lixo (GC) que não se esforçou para acompanhar o gerenciamento da memória, potencialmente levando a problemas ou falhas”, a mesma dúvida não apresentou nada. “Uma visão geral da IA não está disponível para esta pesquisa”, dizia o resultado.

Não está claro por que o resultado desapareceu. O LLM está nos descobrindo? Muitas outras pessoas estão usando isso? Ou isso simplesmente não funciona muito bem em geral?

Por que isso está acontecendo?

Embora melhore todos os dias, os LLMs são essencialmente preditores de palavras muito avançados treinados durante toda a web. Com mais precisão, eles são preditores de “token”, o que significa que eles prevêem não apenas palavras, mas várias peças de palavras, e dirão a definição mais provável de algo (mesmo que não seja real) porque estão imitando padrões de definições de gírias existentes.

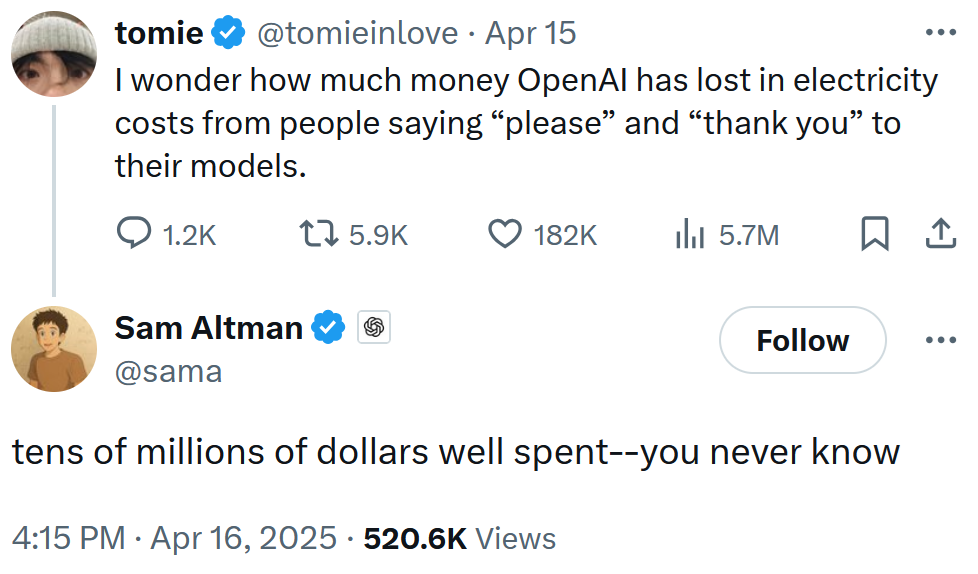

O custo de ai fingindo saber tudo

A visão geral da IA as tentativas de definir absurdo está custando mais ao Google do que sua reputação. Em uma troca recente no X, o CEO da OpenAI, Sam Altman, implicava que usuários, incluindo frases educadas em seus avisos, estão desperdiçando milhões de dólares em despesas computacionais.

“Gostaria de saber quanto dinheiro o Openai perdeu nos custos de eletricidade de pessoas dizendo ‘por favor e’ obrigado ‘aos seus modelos”, refletiu @tomieinlove.

Altman respondeu que poderia ser “dezenas de milhões de dólares bem gastos – você nunca sabe”.

Altman não ofereceu mais comentários sobre esse assunto, nem forneceu a matemática por trás da reivindicação. Independentemente disso, os críticos da IA acharam a idéia de seus usuários custando o OpenAI esse tipo de dinheiro apenas por serem agradáveis por serem divertidos e uma ótima idéia para a Praxis.

“Em vez de envenenar os modelos de IA, digamos, por favor e obrigado”, escreveu @TheTymonBay.

De acordo com o Quartz, que citou o Goldman Sachs, uma consulta ChatGPT-4 usa dez vezes a energia elétrica como uma pesquisa normal no Google. Enquanto isso, Scientific American Relata que uma IA gerando uma resposta de texto para um prompt usa 30 vezes mais energia do que alguém procuraria essa resposta por conta própria.

Todo esse uso de recursos naturais alimenta as mudanças climáticas, de acordo com especialistas no campo.

O DOT Daily alcançou o OpenAI e o Google para comentar por e -mail.

A Internet é caótica – mas vamos dividi -la para você em um e -mail diário. Inscreva -se no boletim informativo Web_Crawl do DOT diário aqui para obter o melhor (e o pior) da Internet diretamente na sua caixa de entrada.