Como o rápido crescimento dos bots pode mudar a web aberta

Como o rápido crescimento dos bots muda a web aberta?

Mais da metade do tráfego da web vem de bots:

- O Bad Bot Report 2024 da Imperva revela que quase 50% do tráfego total da Internet não era humano em 2024. Tendência: declínio.

- O radar da Cloudflare mostra aproximadamente 70% de tráfego humano e 30% de bots.

- Akami relata que 42% do tráfego na web vem de bots.

Até agora, os bots coletaram informações que tornam os aplicativos melhores para os humanos. Mas uma nova espécie cresce em população: os bots agentes.

Durante duas décadas, otimizamos sites para o GoogleBot. Em breve, poderemos nos concentrar em ajudantes de IA que atuam como intermediários entre os humanos e a web aberta.

Já otimizamos para BotNet com Schema e feeds de produtos no Merchant Center do Google. Sitemaps XML tornaram-se apostas há décadas.

No próximo nível, poderíamos ter sites ou APIs separados para bots agentes com um campo de atuação de marketing totalmente novo.

Crédito da imagem: Lyna ™

Crédito da imagem: Lyna ™Web Agente

À medida que estamos chegando perto de obter mais tráfego de bots do que humano na web aberta, é essencial ter em mente que cerca de 65% do tráfego de bots é estimado como malicioso.

Bons bots incluem scrapers de mecanismos de pesquisa, ferramentas de SEO, defesa de segurança e, claro, rastreadores de IA. Ambos os tipos de bots estão crescendo em população, mas apenas os bons são realmente úteis.

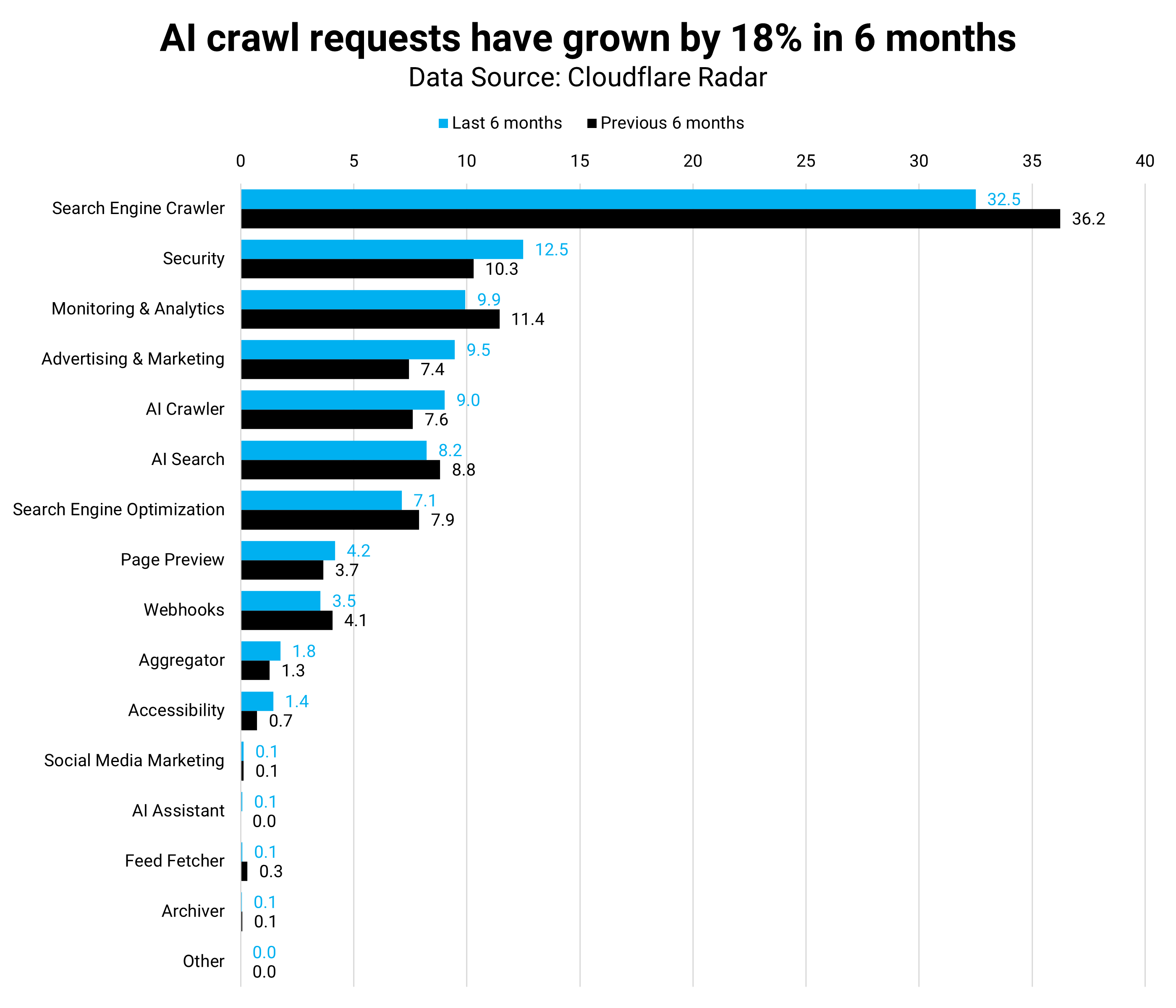

Comparando o último com os seis meses anteriores, os rastreadores de IA cresceram 18%, enquanto os motores de busca desaceleraram 10%. O GoogleBot reduziu especificamente a atividade em -1,6%.

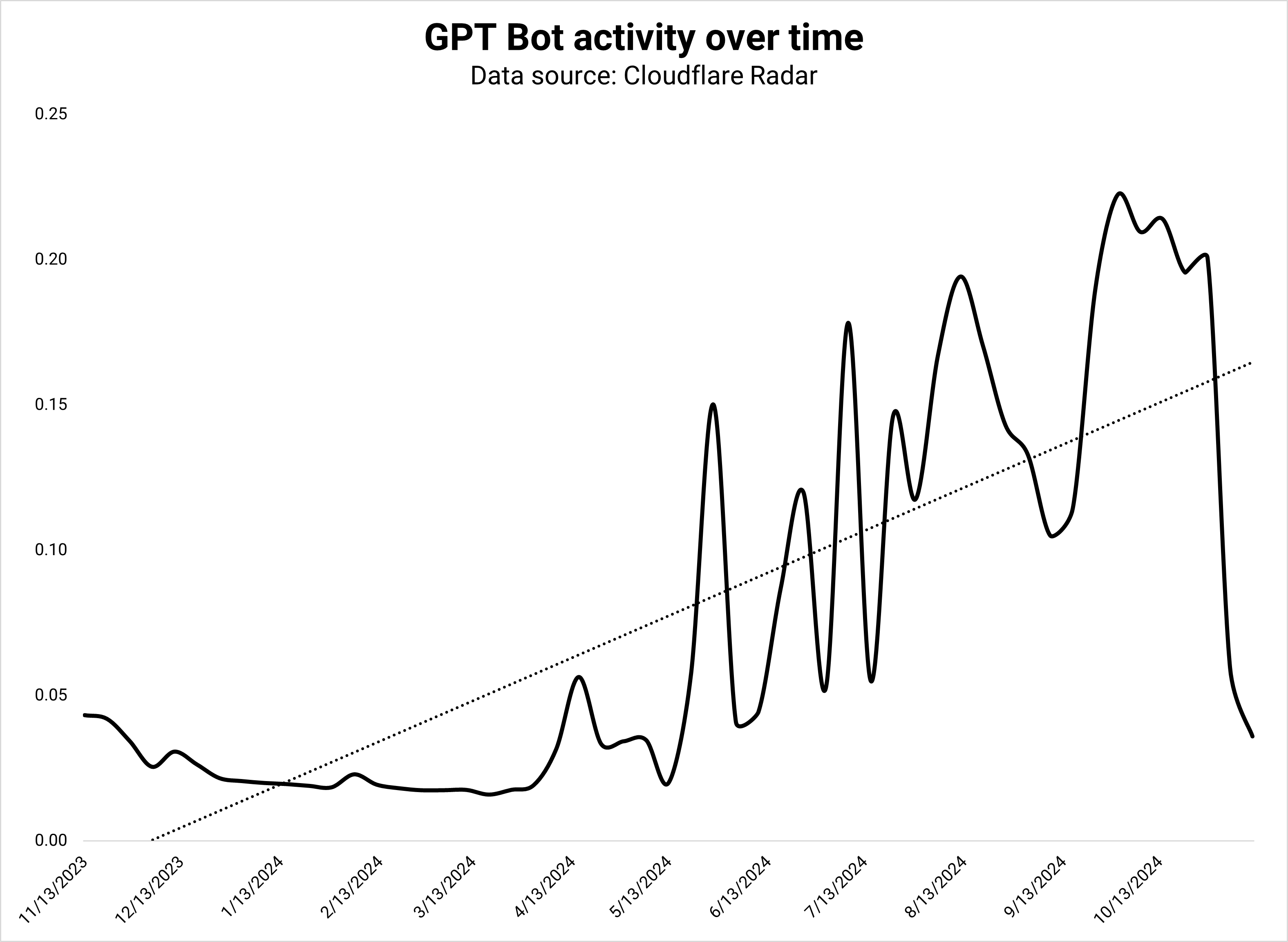

No entanto, o rastreador de IA do Google compensou com um aumento de 1,4%. O GPT Bot foi o rastreador de IA mais ativo, com 3,8% de todas as solicitações – e cresceu 12%.

O rastreador de IA do Google cresceu 62% e foi responsável por 3,7% de todas as solicitações de bots. Dada a sua atual taxa de crescimento, o rastreador de IA do Google deverá em breve ser o mais ativo na web.

Crédito da imagem: Kevin Indig

Crédito da imagem: Kevin IndigHoje, os bots de IA têm três objetivos:

- Colete dados de treinamento.

- Crie um índice de pesquisa para fundamentar as respostas do LLM (RAG).

- Colete dados em tempo real para solicitações que exigem atualização.

Mas atualmente, todos os grandes desenvolvedores de IA trabalham em agentes que navegam na web e agem pelos usuários:

- Claude foi o primeiro com seu recurso de produto “Uso de Computador”: “Os desenvolvedores podem direcionar Claude para usar computadores da mesma forma que as pessoas: olhando para uma tela, movendo um cursor, clicando em botões e digitando texto”.

- Jarvis do Google, “um companheiro útil que navega na web para você”, foi lançado acidentalmente na loja do Chrome momentaneamente.

- OpenAI funciona no “Operador”, também um agente que age por você.

Vejo três resultados possíveis:

- Os agentes aumentam significativamente o tráfego de bots na web aberta à medida que rastreiam e visitam sites.

- Agentes usam APIs para obter informações.

- Os Agentes operam em sua plataforma, o que significa que o Operador usa apenas dados do ChatGPT em vez de coletar os seus próprios.

Acho que é mais provável que haja uma combinação dos três, com o resultado de que o tráfego de bots cresceria significativamente.

Se isso for verdade, as empresas criarão cada vez mais versões separadas de seus sites para bots voltadas para velocidade e dados estruturados. “Foco apenas no usuário” torna-se “foco apenas nos agentes”.

De certa forma, Pesquisa ChatGPT já é um agente que navega e faz curadoria da web para humanos. Mas se os agentes cumprirem a promessa, você pode esperar muito mais.

CEO da OpenAI, Sam Altman disse em seu recente Reddit OU, “Acho que o próximo grande avanço serão os agentes.”

À medida que os bots conquistam a web, o que os humanos estão fazendo?

Adoção da Internet

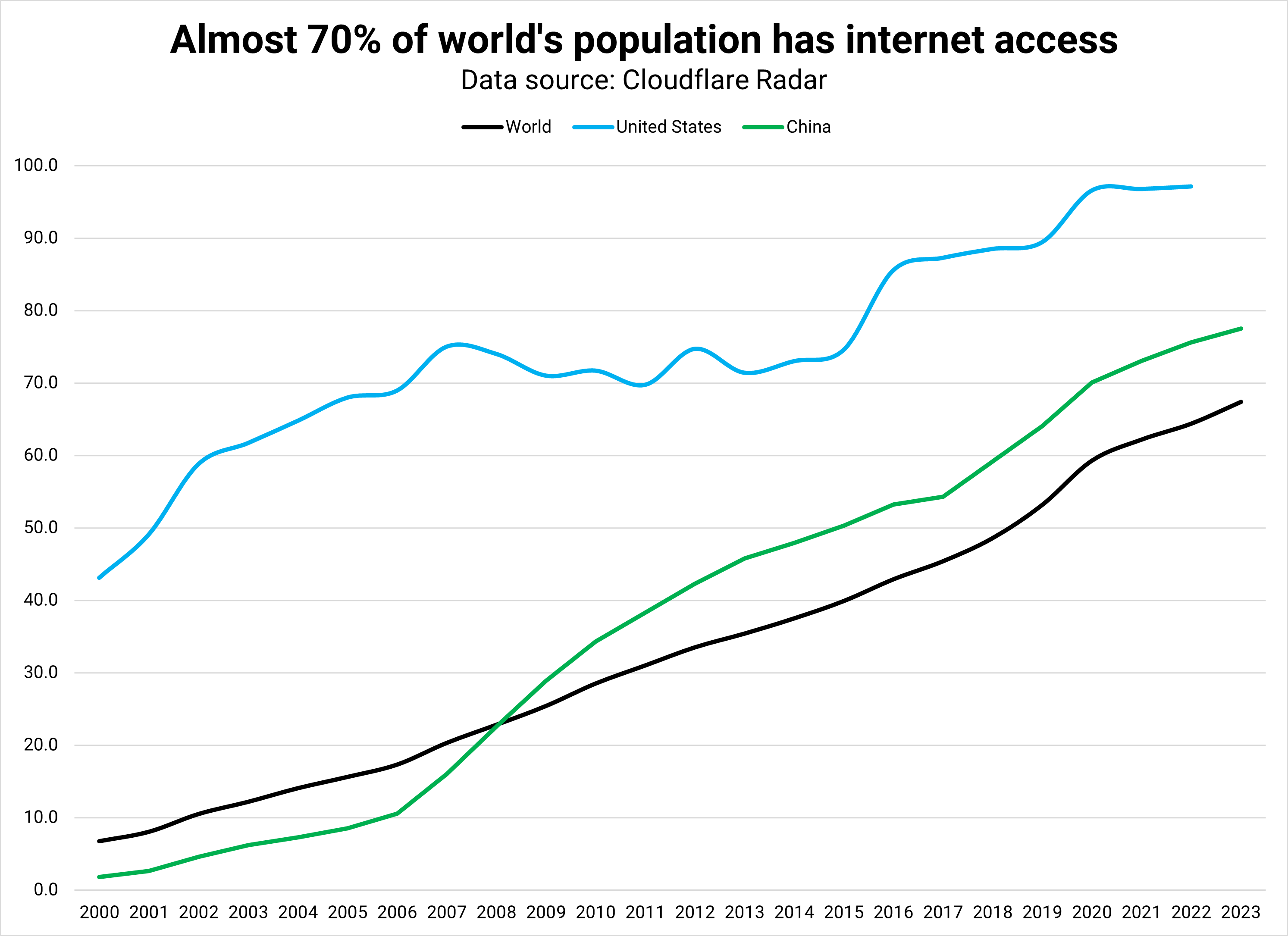

Crédito da imagem: Kevin Indig

Crédito da imagem: Kevin IndigÉ improvável que os humanos parem de navegar completamente na web.

Mesmo com respostas de IA nos recursos de pesquisa e pesquisa em chatbots de IA, os humanos ainda desejam verificar as declarações de IA, obter inspiração aleatória (serendipidade) ou buscar respostas de outros humanos (Reddit).

Mas o ato de navegar para pesquisar provavelmente se dissolverá em avisos se os bots forem bons o suficiente.

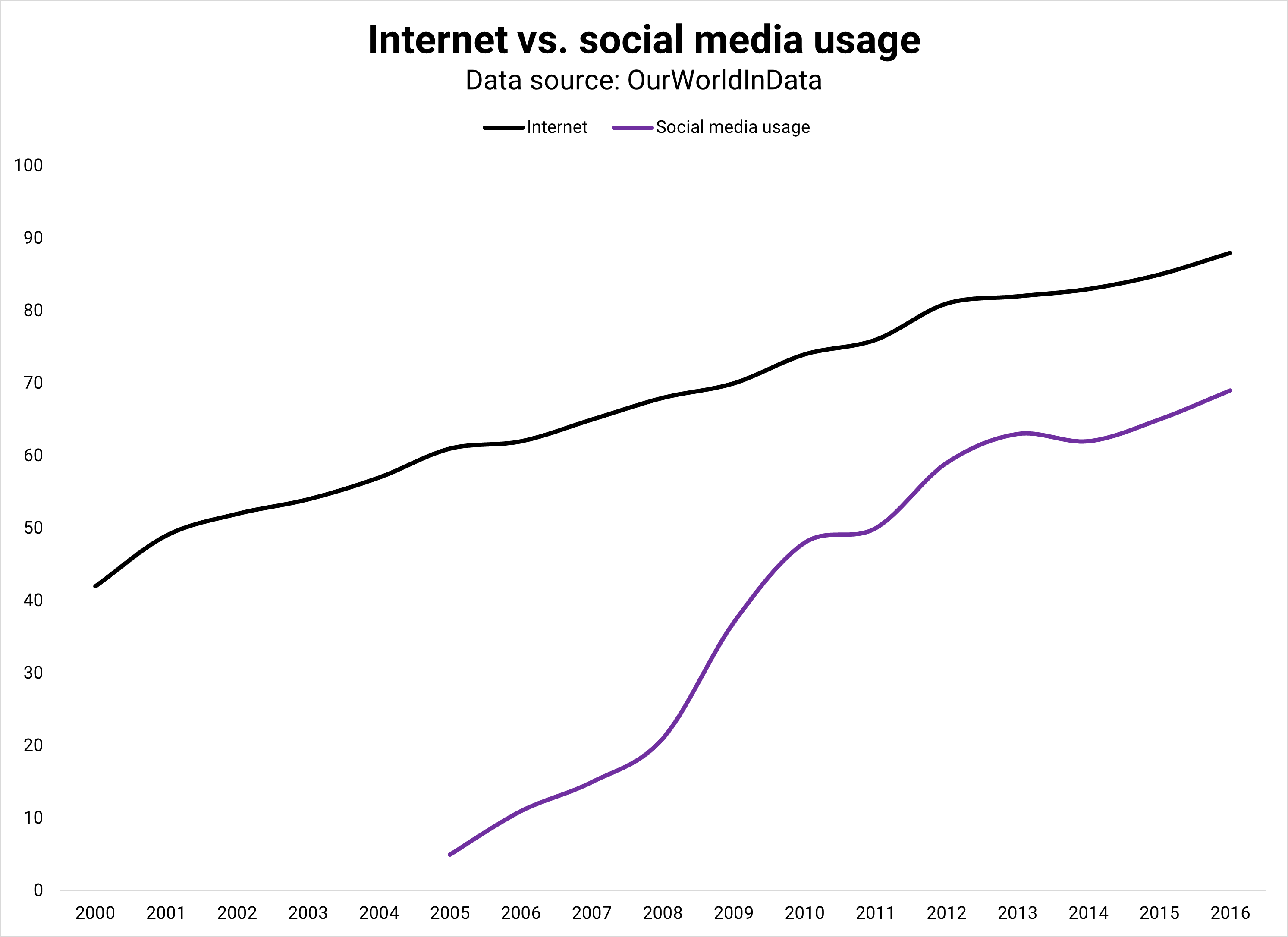

Há espaço para crescimento no tráfego humano: 70% da população mundial tinha acesso à Internet em 2023. Ao ritmo atual (~7% A/A), o mundo inteiro teria acesso à Internet até 2030.

No entanto, apesar da crescente adoção da Internet, o tráfego humano permaneceu estável nos últimos três anos (consulte as estatísticas da Cloudflare). Os rastreadores de IA crescem muito mais rápido (18%) e os agentes podem acelerar ainda mais.

Crédito da imagem: Kevin Indig

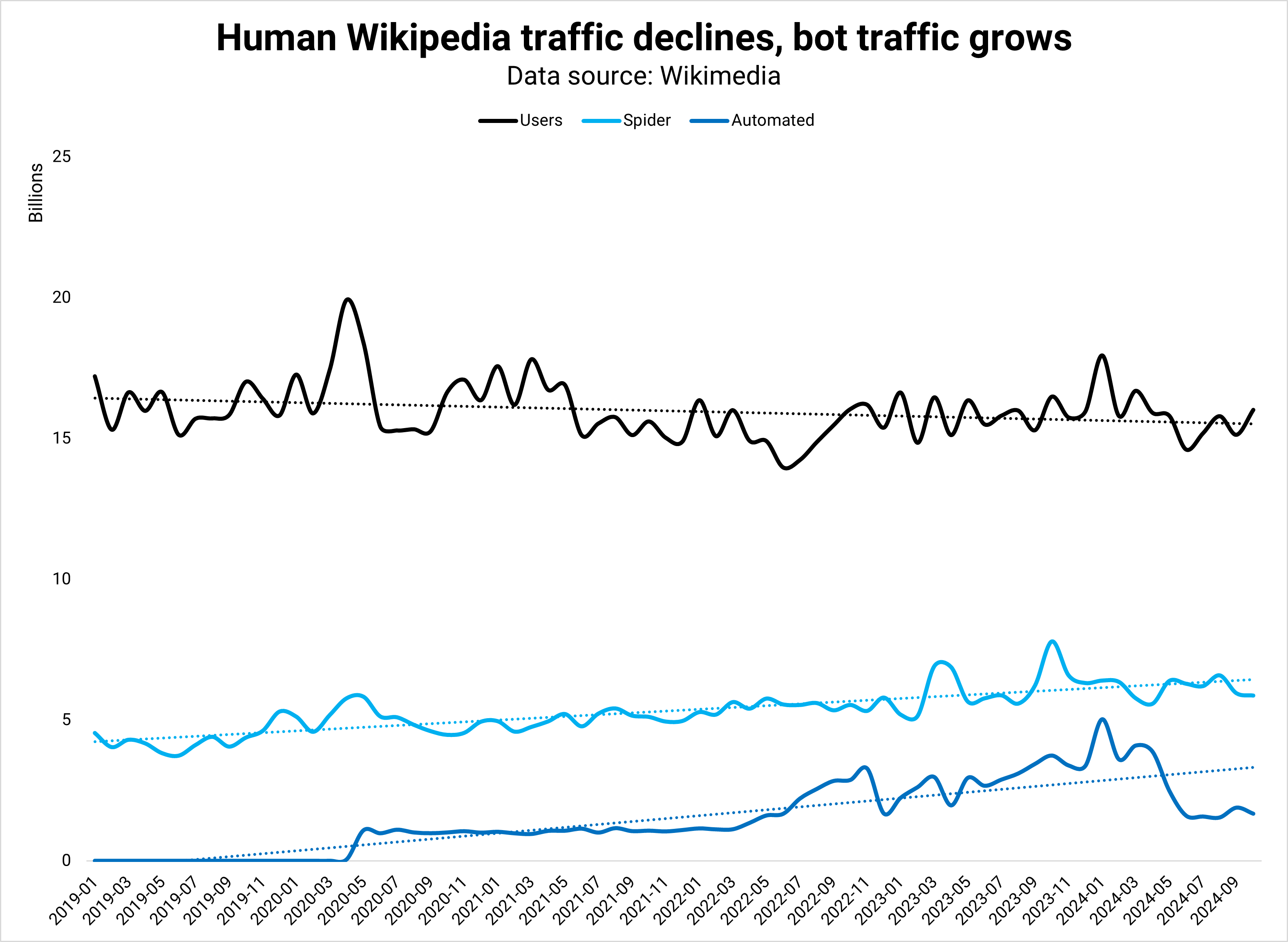

Crédito da imagem: Kevin IndigAs solicitações humanas à Wikipédia, o maior site da web, estagnaram desde 2019.

A razão é que a atenção humana se desloca para as plataformas sociais, especialmente para as gerações mais jovens. À medida que os bots invadem a web aberta, os humanos fogem para retiros de engajamento.

Marketing

Crédito da imagem: Kevin Indig

Crédito da imagem: Kevin IndigNum futuro distante, bons bots poderão tornar-se cidadãos de direitos iguais da nação da web aberta, à medida que mais humanos passam tempo em plataformas sociais fechadas e os LLMs de agência aumentam o já rápido crescimento do tráfego de bots. Se essa teoria se concretizar, o que isso significa para o marketing e, especificamente, para o SEO?

Imagine reservar uma viagem. Em vez de navegar no Google ou no Booking, você diz ao seu agente onde pensa ir e quando.

Com base no que sabe sobre suas preferências, seu agente seleciona três opções de voos e hotéis na plataforma de sua preferência.

Quando você escolhe um voo, ele é adicionado ao seu calendário e os ingressos ficam na sua caixa de entrada. Você não precisa finalizar a compra. O agente faz tudo por você. Você poderia aplicar o mesmo cenário ao comércio eletrônico ou software.

Dado que empresas como o Google já têm capacidade para construir isso hoje, vale a pena pensar no que permaneceria constante, o que mudaria e o que se tornaria cada vez menos importante nesta visão.

Constante

Os bots não precisam de CSS ou imagens hero. Não há nenhuma desvantagem em ocultar seu site para rastreadores LLM, então há uma chance de que os sites mostrem aos bots uma versão básica.

Um conjunto de habilidades que permanece constante neste futuro é o SEO técnico: rastreabilidade, velocidade (do servidor), links internos e dados estruturados.

Mudar

Uma web aberta agente oferece recursos de segmentação de anúncios muito melhores, já que os bots conhecem seus proprietários de dentro para fora.

Os humanos tomarão decisões de compra muito mais rapidamente, uma vez que os seus agentes lhes fornecem todas as informações de que necessitam e conhecem as suas preferências.

Os custos de publicidade caem significativamente e oferecem retornos ainda maiores do que já são hoje.

Como os bots podem traduzir qualquer coisa em segundos, a localização e as vendas internacionais não são mais um problema. Os humanos podem comprar de qualquer pessoa, em qualquer lugar – apenas com restrições de envio e estoque. A economia global abre-se ainda mais.

Se agirmos corretamente, os agentes poderão ser os melhores guardiões da privacidade: ninguém tem tantos dados sobre você quanto eles, mas você pode controlar o quanto eles compartilham.

Os agentes conhecem você, mas não precisam compartilhar essas informações com outras pessoas. Poderíamos compartilhar ainda mais dados com eles, girando o volante do valor de dados → compreensão → resultados → dados → valor → resultados → etc.

Por outro lado, precisamos construir defesas contra bots desonestos, redefinindo o que os bots podem fazer em um formato semelhante ao robots.txt 2.0. A segurança cibernética tornou-se ainda mais importante, mas também mais complexa, uma vez que os bots ruins podem imitar muito melhor os bons.

Precisaremos descobrir o impacto ambiental do maior consumo de energia devido ao maior tráfego de bots.

Esperançosamente, os bots serão mais eficientes e, portanto, causarão menos tráfego total na web do que os humanos. Isso compensaria, pelo menos um pouco, o consumo de energia que os LLMs já estão causando.

Importante

O formato de informação mais amigável para bots é bruto e estruturado: XML, RSS e feeds de API. Já enviamos feeds de produtos e mapas de sites XML ao Google, mas os agentes vão querer mais.

O design da Web será menos importante no futuro, e talvez não haja problema, já que a maioria dos sites parece muito semelhante.

O design do feed se torna mais importante: quais informações incluir nos feeds, quanto, com que frequência atualizá-las e quais solicitações enviar de volta aos bots.

Os profissionais de marketing gastarão muito mais tempo fazendo engenharia reversa da aparência das conversas com chatbots. Os bots provavelmente serão uma caixa preta como o algoritmo do Google, mas a publicidade poderá esclarecer o que as pessoas mais perguntam.

Relacionamentos

No futuro agente, será difícil fazer com que os clientes mudem depois que eles escolherem uma marca de que gostam, até que tenham uma experiência ruim.

Com isso, uma importante alavanca de marketing será fazer com que os clientes experimentem sua marca com campanhas como descontos e ofertas exclusivas.

Depois de ter convicção e sinalizar que seu produto é melhor, a missão passa a ser persuadir os usuários a experimentá-lo. Obviamente, isso já funciona hoje.

Com tantas oportunidades de anunciar e influenciar os usuários organicamente para um produto específico antes de comprá-los, temos muito mais influência na compra.

Mas, no futuro, os agentes poderão fazer essas escolhas para os usuários. Os profissionais de marketing gastarão mais tempo na construção de relacionamentos, no reconhecimento da marca e na influência fatores de marketing da velha escola como preços, distribuição (frete) e diferenciação.

Radar Cloudflare: tendências de tráfego

Os bots representam 42% do tráfego geral da Web; Quase dois terços são maliciosos

Radar Cloudflare: explorador de dados

Apresentando o uso do computador, um novo Claude 3.5 Sonnet e Claude 3.5 Haiku

A existência da extensão Jarvis AI do Google vazou na loja do Chrome

OpenAI se aproxima do lançamento da ferramenta AI Agent para automatizar tarefas para usuários

Análise de visualizações de sites

Imagem em destaque: Paul Poetry/Search Engine Journal